Trí tuệ nhân tạo (AI), đặc biệt là Generative AI, không còn là công nghệ của tương lai mà đã trở thành động lực cốt lõi trong hoạt động của nhiều doanh nghiệp. Tuy nhiên, song song với tiềm năng khổng lồ là những thách thức chưa từng có về mặt đạo đức và pháp lý. Đối với các CTO và nhà quản lý công nghệ, việc xây dựng một chiến lược AI có trách nhiệm (Responsible AI) không chỉ là yêu cầu tuân thủ mà còn là yếu tố sống còn để bảo vệ danh tiếng và đảm bảo sự phát triển bền vững.

Bài viết này cung cấp một lộ trình chi tiết, giúp các nhà lãnh đạo nhận diện rủi ro, nắm bắt khung pháp lý và xây dựng nền tảng đạo đức vững chắc cho việc ứng dụng AI.

Tổng quan về AI Ethics và bối cảnh pháp lý hiện tại

Bước vào kỷ nguyên AI, việc hiểu rõ các nguyên tắc đạo đức và bối cảnh pháp lý là điều kiện tiên quyết để doanh nghiệp không đi chệch hướng và đối mặt với các rủi ro khôn lường.

AI Ethics là gì? Các nguyên tắc cốt lõi cho doanh nghiệp

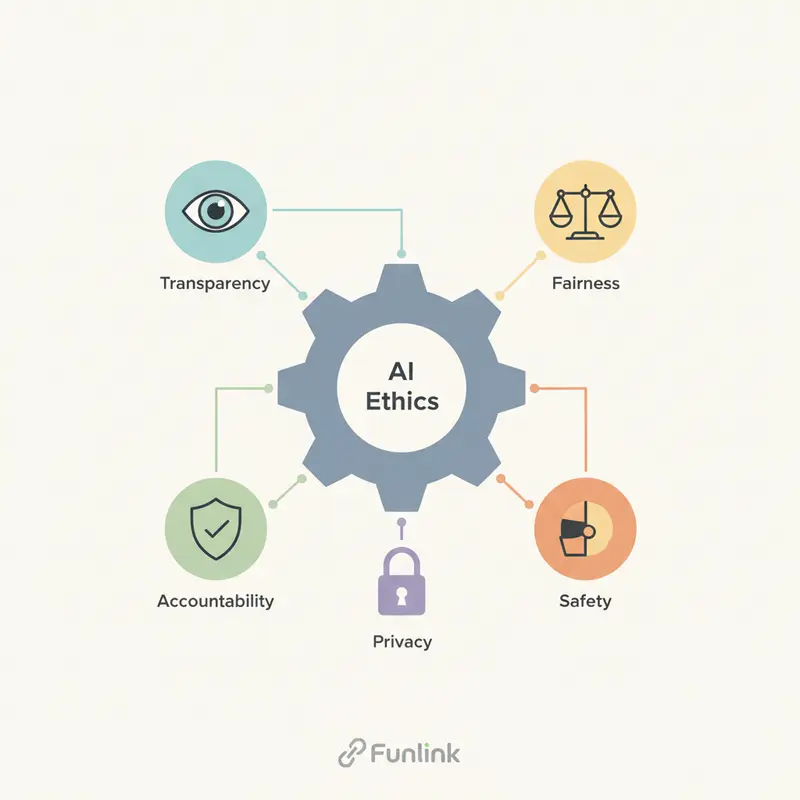

Đạo đức AI (AI Ethics) là một nhánh của đạo đức ứng dụng, tập trung vào các vấn đề đạo đức và xã hội phát sinh từ việc thiết kế, phát triển và triển khai trí tuệ nhân tạo. Nó không chỉ đơn thuần là tuân thủ luật pháp, mà còn là cam kết xây dựng các hệ thống AI công bằng, minh bạch và phục vụ lợi ích con người. Các nguyên tắc cốt lõi bao gồm:

- Minh bạch (Transparency): Khả năng giải thích cách AI đưa ra quyết định (Explainable AI – XAI).

- Công bằng (Fairness): Đảm bảo AI không tạo ra hoặc củng cố sự thiên vị, phân biệt đối xử.

- Trách nhiệm (Accountability): Xác định rõ ai chịu trách nhiệm khi hệ thống AI gây ra sai sót hoặc thiệt hại.

- Bảo mật (Privacy): Tôn trọng và bảo vệ quyền riêng tư, dữ liệu cá nhân của người dùng.

- An toàn và Đáng tin cậy (Safety & Reliability): Đảm bảo AI hoạt động ổn định, an toàn và đúng như dự định.

Tại sao vấn đề đạo đức AI trở nên cấp bách trong kỷ nguyên Generative AI?

Generative AI có khả năng tự tạo ra nội dung mới (văn bản, hình ảnh, âm thanh) dựa trên dữ liệu đã học. Chính khả năng này đã khuếch đại các rủi ro đạo đức lên một tầm cao mới: từ việc tạo ra thông tin sai lệch (misinformation), deepfake tinh vi, cho đến các vấn đề vi phạm bản quyền khi sử dụng dữ liệu huấn luyện không phép. Tốc độ phát triển chóng mặt của công nghệ này đòi hỏi một sự quan tâm cấp bách và chủ động từ các nhà quản lý.

Vai trò của CTO trong việc dẫn dắt chiến lược Responsible AI

CTO không chỉ là người dẫn dắt về công nghệ mà còn là người định hình văn hóa đạo đức trong việc ứng dụng AI. Vai trò của họ bao gồm:

- Thiết lập tầm nhìn: Xây dựng một lộ trình rõ ràng về việc tích hợp các nguyên tắc đạo đức vào vòng đời phát triển sản phẩm AI.

- Quản lý rủi ro: Chủ động nhận diện, đánh giá và giảm thiểu các rủi ro pháp lý, đạo đức và danh tiếng.

- Xây dựng năng lực: Đào tạo đội ngũ kỹ sư và các bên liên quan về tầm quan trọng của Responsible AI.

- Thúc đẩy văn hóa: Tạo ra một môi trường nơi các vấn đề đạo đức được thảo luận cởi mở và được coi là một phần không thể thiếu của quá trình đổi mới.

Nhận diện rủi ro: Những cạm bẫy pháp lý và đạo đức khi triển khai AI

Việc triển khai AI mà không có sự đánh giá rủi ro kỹ lưỡng có thể ví như “đi trong bóng tối”, tiềm ẩn nhiều cạm bẫy có thể gây tổn hại nghiêm trọng cho doanh nghiệp.

Rủi ro thiên vị (Bias) và phân biệt đối xử trong các mô hình AI

Các mô hình AI học từ dữ liệu trong quá khứ. Nếu dữ liệu đầu vào chứa đựng những định kiến xã hội, AI sẽ học và tái tạo, thậm chí khuếch đại chúng. Ví dụ, một AI tuyển dụng được huấn luyện trên dữ liệu lịch sử có thể ưu tiên ứng viên nam, hay một hệ thống tín dụng có thể đưa ra quyết định bất lợi cho các nhóm thiểu số. Hậu quả không chỉ là vấn đề đạo đức mà còn là các vụ kiện pháp lý tốn kém.

Thách thức về bảo mật dữ liệu và quyền riêng tư người dùng

Các hệ thống AI, đặc biệt là các mô hình ngôn ngữ lớn (LLMs), đòi hỏi một khối lượng dữ liệu khổng lồ để huấn luyện. Việc thu thập, lưu trữ và xử lý dữ liệu này làm dấy lên lo ngại về quyền riêng tư. Một sự cố rò rỉ dữ liệu không chỉ vi phạm các quy định như GDPR mà còn làm xói mòn nghiêm trọng niềm tin của khách hàng.

Deepfake risks: Khủng hoảng danh tiếng và lừa đảo doanh nghiệp

Công nghệ deepfake, một ứng dụng của Generative AI, có thể tạo ra các video, âm thanh giả mạo cực kỳ chân thực. Tội phạm mạng có thể sử dụng công nghệ này để mạo danh CEO yêu cầu chuyển tiền, tạo ra các chiến dịch bôi nhọ danh tiếng đối thủ, hoặc lừa đảo khách hàng. Đây là một mối đe dọa trực tiếp và hiện hữu đối với an ninh và uy tín của doanh nghiệp.

Cuộc chiến bản quyền: Khi AI sáng tạo và luật bản quyền AI chưa theo kịp

Một trong những “vùng xám” pháp lý lớn nhất hiện nay là sự giao thoa giữa AI và luật sở hữu trí tuệ. Các quy định hiện hành vốn được thiết kế cho con người đang gặp khó khăn khi áp dụng cho các tác nhân phi con người.

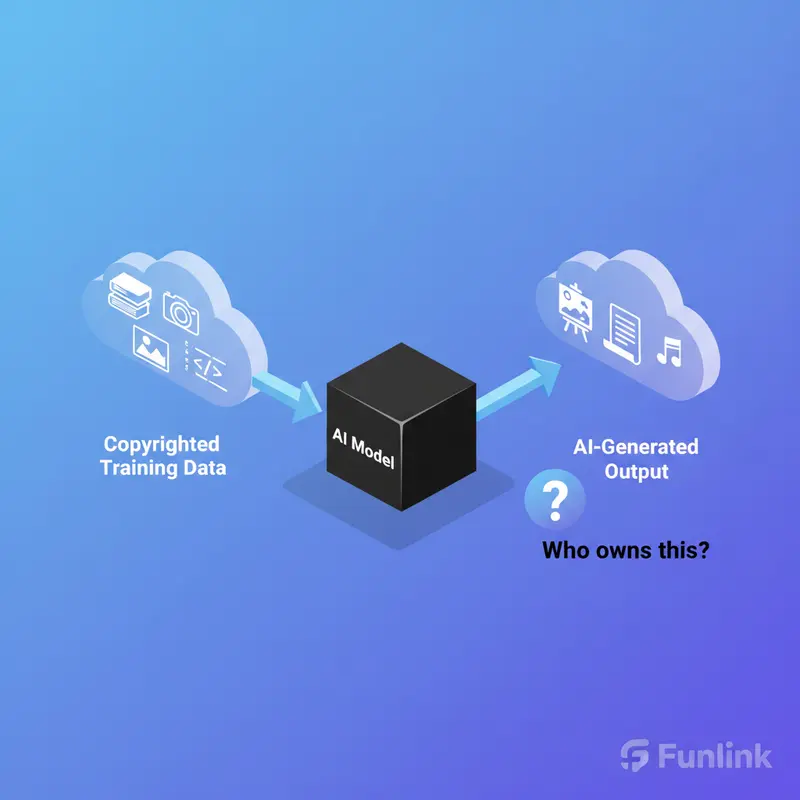

Dữ liệu huấn luyện AI có vi phạm bản quyền không?

Phần lớn các mô hình Generative AI hàng đầu được huấn luyện bằng cách “cào” dữ liệu khổng lồ từ Internet, bao gồm hàng tỷ hình ảnh, bài viết, mã nguồn có bản quyền mà không có sự cho phép của tác giả. Các công ty AI lập luận rằng đây là hành vi “sử dụng hợp lý” (fair use) cho mục đích nghiên cứu và phát triển. Tuy nhiên, các nhà sáng tạo và chủ sở hữu nội dung lại cho rằng đây là hành vi vi phạm bản quyền trắng trợn. Các vụ kiện lớn chống lại Stability AI, Midjourney và OpenAI đang diễn ra và kết quả của chúng sẽ định hình tương lai của ngành.

Ai sở hữu tác phẩm do AI tạo ra? Vấn đề pháp lý nan giải

Câu hỏi hóc búa tiếp theo: Nếu một tác phẩm được tạo ra hoàn toàn bởi AI, ai là chủ sở hữu bản quyền? Người dùng đưa ra câu lệnh (prompt)? Công ty phát triển AI? Hay chính AI? Quan điểm hiện tại của nhiều cơ quan pháp lý, bao gồm cả Văn phòng Bản quyền Hoa Kỳ, là một tác phẩm phải có sự can thiệp đáng kể của con người mới đủ điều kiện được bảo hộ bản quyền. Điều này tạo ra một khoảng trống pháp lý lớn cho các ngành công nghiệp sáng tạo dựa trên AI.

Phân tích quan điểm từ Copyright Office Hoa Kỳ và các tổ chức liên quan

Văn phòng Bản quyền Hoa Kỳ (U.S. Copyright Office) đã đưa ra hướng dẫn ban đầu, khẳng định rằng các tác phẩm do AI tạo ra mà không có sự sáng tạo của con người thì không được bảo hộ. Tuy nhiên, họ vẫn để ngỏ khả năng bảo hộ cho các tác phẩm mà AI chỉ đóng vai trò là một công cụ hỗ trợ, dưới sự chỉ đạo và sáng tạo của con người. Sự phân định ranh giới này vẫn còn rất mơ hồ và đang được tranh luận sôi nổi.

Khung pháp lý toàn cầu: Từ EU AI Act đến các quy định tiên phong

Trước sự phát triển nhanh chóng của AI, các chính phủ trên toàn thế giới đang gấp rút xây dựng các khung pháp lý để quản lý công nghệ này. Việc nắm bắt các xu hướng này giúp doanh nghiệp chuẩn bị và thích ứng kịp thời.

Phân tích các cấp độ rủi ro trong đạo luật EU AI Act

Đạo luật AI của Liên minh Châu Âu (EU AI Act) được xem là một trong những bộ quy tắc toàn diện đầu tiên trên thế giới. Nó tiếp cận dựa trên rủi ro, phân loại các ứng dụng AI vào 4 cấp độ:

- Rủi ro không thể chấp nhận (Unacceptable Risk): Bị cấm hoàn toàn (ví dụ: hệ thống chấm điểm công dân xã hội).

- Rủi ro cao (High Risk): Chịu sự quản lý nghiêm ngặt (ví dụ: AI trong y tế, tuyển dụng, tín dụng).

- Rủi ro giới hạn (Limited Risk): Yêu cầu về minh bạch (ví dụ: chatbot phải thông báo cho người dùng rằng họ đang tương tác với AI).

- Rủi ro tối thiểu (Minimal Risk): Không có quy định bắt buộc.

Case study: Các vụ kiện lớn liên quan đến bản quyền và Generative AI

- Getty Images kiện Stability AI: Hãng ảnh hàng đầu thế giới kiện nhà phát triển Stable Diffusion vì sử dụng hàng triệu hình ảnh có bản quyền của họ để huấn luyện AI mà không xin phép.

- Nhóm nghệ sĩ kiện Midjourney và DeviantArt: Một vụ kiện tập thể cáo buộc các nền tảng này vi phạm bản quyền của hàng triệu nghệ sĩ khi sử dụng tác phẩm của họ để tạo ra các công cụ AI art generator.

- The New York Times kiện OpenAI và Microsoft: Tờ báo danh tiếng kiện các công ty công nghệ vì sử dụng hàng triệu bài báo của họ để huấn luyện ChatGPT, cho rằng điều này cạnh tranh trực tiếp và làm giảm giá trị sản phẩm của họ.

Những vụ kiện này là phép thử quan trọng cho luật bản quyền trong kỷ nguyên số và sẽ tạo ra những tiền lệ pháp lý quan trọng.

Xu hướng lập pháp về AI tại Châu Á và Việt Nam cho nhà quản lý

Tại Châu Á, các quốc gia như Trung Quốc, Singapore và Nhật Bản cũng đang tích cực xây dựng các quy định riêng. Việt Nam cũng không đứng ngoài cuộc chơi, với việc Chính phủ đã ban hành các chiến lược và chỉ thị về nghiên cứu, phát triển và ứng dụng AI. Các nhà quản lý cần theo dõi sát sao các dự thảo luật và quy định liên quan đến bảo vệ dữ liệu, giao dịch điện tử và sở hữu trí tuệ để đảm bảo tuân thủ.

Xây dựng nền tảng Responsible AI: Khung chính sách cho doanh nghiệp

Thay vì chờ đợi các quy định hoàn chỉnh, doanh nghiệp nên chủ động xây dựng một khung chính sách nội bộ về AI có trách nhiệm. Điều này không chỉ giúp giảm thiểu rủi ro mà còn tạo ra lợi thế cạnh tranh và xây dựng niềm tin với khách hàng.

Bước 1: Thành lập hội đồng giám sát đạo đức AI nội bộ

Thành lập một hội đồng đa chức năng bao gồm đại diện từ pháp lý, công nghệ, sản phẩm và kinh doanh. Nhiệm vụ của hội đồng là xem xét, đánh giá các dự án AI dưới lăng kính đạo đức, đưa ra các khuyến nghị và giám sát việc tuân thủ chính sách.

Bước 2: Đánh giá và kiểm toán thuật toán (Algorithm Audit)

Thực hiện kiểm toán định kỳ các mô hình AI để phát hiện và khắc phục các vấn đề về thiên vị (bias). Sử dụng các bộ dữ liệu kiểm tra đa dạng và các công cụ chuyên dụng để đảm bảo tính công bằng và chính xác của thuật toán.

Bước 3: Xây dựng quy trình sử dụng và ghi nhận nguồn dữ liệu

Thiết lập một quy trình rõ ràng về nguồn gốc dữ liệu được sử dụng để huấn luyện AI. Ưu tiên sử dụng dữ liệu được cấp phép hợp lệ, dữ liệu công khai (public domain) hoặc dữ liệu tổng hợp (synthetic data). Ghi nhận và lưu trữ tài liệu về nguồn gốc dữ liệu để đảm bảo tính minh bạch và khả năng truy xuất nguồn gốc.

Checklist: Các tiêu chí cần có trong một chính sách Responsible AI

Một chính sách toàn diện cần bao gồm các mục tiêu rõ ràng, vai trò và trách nhiệm cụ thể, quy trình đánh giá rủi ro, yêu cầu về minh bạch và giải thích được, các biện pháp bảo vệ dữ liệu, và kế hoạch ứng phó khi có sự cố xảy ra.

Tương lai của đạo đức AI và bản quyền: Dự báo cho các nhà lãnh đạo công nghệ

Lĩnh vực AI và pháp lý đang phát triển với tốc độ chưa từng thấy. Các nhà lãnh đạo cần có tầm nhìn xa để đón đầu những thay đổi sắp tới.

Dự báo các thay đổi trong luật bản quyền AI 5 năm tới

Trong 5 năm tới, chúng ta có thể sẽ chứng kiến sự ra đời của các luật chuyên biệt về AI. Các khái niệm như “quyền sử dụng hợp lý” cho dữ liệu huấn luyện có thể sẽ được định nghĩa lại. Khả năng cao sẽ có các cơ chế cấp phép mới cho việc sử dụng dữ liệu có bản quyền và thậm chí là một hình thức bảo hộ giới hạn cho các tác phẩm do AI tạo ra.

Công nghệ mới giúp truy vết và xác thực nội dung do AI tạo ra

Để chống lại deepfake và thông tin sai lệch, các công nghệ như “digital watermarking” (nhúng chữ ký số ẩn vào nội dung) và các tiêu chuẩn như C2PA (Coalition for Content Provenance and Authenticity) sẽ trở nên phổ biến. Những công nghệ này giúp xác thực nguồn gốc và tính toàn vẹn của nội dung số, tăng cường sự minh bạch và tin cậy.

Đề xuất liên kết nội bộ: Khám phá các xu hướng Generative AI năm 2024

Để duy trì lợi thế cạnh tranh và hiểu sâu hơn về bối cảnh công nghệ đang thay đổi nhanh chóng, các nhà lãnh đạo cần cập nhật liên tục. Tham khảo thêm: Khám phá các Xu hướng Generative AI năm 2024 để có cái nhìn toàn diện hơn.